TL;DR:

CO₂-Fußabdruck von KI-Modellen reduzieren

Hintergrund:

-

KI-Modelle wie GPT-4o verursachen beim Training hohe CO₂-Emissionen (mehrere 100 t CO₂ pro Lauf).

-

Ziel: Ökologische Nachhaltigkeit ohne Leistungsverlust durch präzise Messung und gezielte Optimierung.

Messung des CO₂-Fußabdrucks:

-

Tools wie CodeCarbon, CarbonTracker und Eco2AI messen den Energieverbrauch während des Trainings.

-

Wichtige Faktoren: Modellgröße, Hardwaretyp, Trainingsdauer, Strommix, PUE, Batch Size, Epochen.

Best Practices zur Reduktion:

-

Energieeffiziente Infrastruktur: GPUs/TPUs statt CPUs, nachhaltige Cloud-Anbieter.

-

Training optimieren: Early Stopping, Mixed Precision, große Batch Size, reduzierte Epochenanzahl.

-

Effiziente Verfahren: Random/Bayesian Search statt Grid Search, kompakte Modelle (Pruning, Quantisierung).

Fazit:

-

Nachhaltige KI ist technisch machbar und dringend notwendig.

-

Durch bewusste Modell- und Infrastrukturwahl lassen sich CO₂-Emissionen deutlich senken – ohne signifikante Qualitätseinbußen.

Sustainable AI (nachhaltige KI) ist eine Schlüsseltechnologie der digitalen Transformation, die es ermöglicht, die Umweltauswirkungen von KI-Systemen zu minimieren, während gleichzeitig deren Vorteile maximiert werden. Diese Technologie spielt eine entscheidende Rolle in nahezu allen Branchen, vom Gesundheitswesen bis zum Finanzsektor, und fördert Innovationen, die unser tägliches Leben verbessern. Allerdings gehen die Fortschritte in der Künstlichen Intelligenz auch mit erheblichen Umweltkosten einher. Insbesondere große ML-Modelle benötigen immense Rechenleistung, was zu hohen CO2-Emissionen führt.

Ich selbst habe Umweltinformatik studiert und interessiere mich schon immer für KI. Zusammen mit dem Nachhaltigkeitsteam bin ich deshalb auch auf das Thema meiner Bachelorarbeit gekommen:

Die Messung und Reduktion des CO2-Fußabdrucks von ML-Modellen in der Trainingsphase. Dabei konzentrierte ich mich auf das Modell DistilBERT für Sentiment-Analysen und testete verschiedene Optimierungsmöglichkeiten. Ziel war es, nachhaltige ML-Praktiken zu etablieren, die nicht nur die Effizienz der Modelle verbessern, sondern auch deren ökologische Auswirkungen verringern.

Die Umweltkosten des Machine Learning

Künstliche Intelligenz erfordert immense Rechenleistung, insbesondere in der Trainingsphase. Ein einziges Modell kann mehrere Hundert Tonnen CO2 emittieren – so viel wie ein Auto in seiner gesamten Lebensdauer. Es wird dabei geschätzt, dass moderne Modelle wie ChatGPT-4o pro Trainingslauf etwa 20-25 Megawatt Strom verbrauchen können – genug, um 20.000 amerikanische Haushalte 3 Monate mit Strom zu versorgen.

Dabei gibt es mehrere Gründe für den hohen Energieverbrauch:

- Rechenzentren mit hohem Strombedarf – GPUs und TPUs verbrauchen enorm viel Energie.

- Lange Trainingszeiten – komplexe Modelle erfordern oft Wochen oder Monate an Trainingszeiten.

- Ineffiziente Algorithmen – manche Verfahren nutzen die verfügbare Rechenleistung nicht optimal.

Sustainable AI ist daher essenziell. Es geht darum, energieeffiziente Modelle zu entwickeln, ohne die Leistungsfähigkeit signifikant zu beeinträchtigen.

Wie misst man den CO2-Fußabdruck von KI-Modellen?

Zur Reduktion von Emissionen müssen wir sie zuerst genau messen. Dazu gibt es spezialisierte CO2-Tracking-Tools, wie zum Beispiel:

Diese Tracking-Tools laufen meist auf allen gängigen Betriebssystemen und sind je nach Programm mit unterschiedlich viel Hardware kompatibel. Zusätzlich bieten einige Cloud-Anbieter Nachhaltigkeitsmetriken, um den Energieverbrauch zu analysieren. Unternehmen, die große ML-Modelle trainieren, sollten solche Tools in ihre Trainingsprozesse integrieren.

Welche Faktoren beeinflussen den Energieverbrauch?

Es gibt viele verschiedene Faktoren, die den Energieverbrauch beeinflussen können. Anhand von distilBERT konnte ich dabei folgende Einflussfaktoren ausgemachen:

- Modell: Der Energieverbrauch ist abhängig von der Größe des benutzten Modells.

- Hyperparameter: Verwendete Hyperparameter wie z. B. Batch Size beeinflussen den Energieverbrauch erheblich.

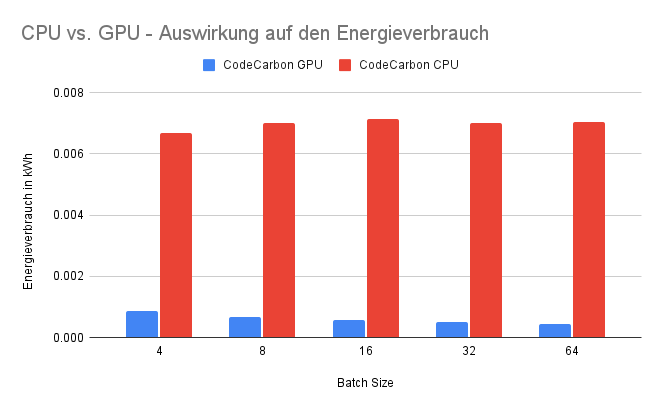

- Hardwaretyp: GPUs und CPUs unterscheiden sich stark in Energieeffizienz und Leistungsfähigkeit.

- Anzahl der Hardware: Die Anzahl der genutzten Hardware beeinflusst den Energieverbrauch erheblich.

- Nutzungsintensität: Der tatsächliche Auslastungsgrad der Hardware beeinflusst den Energieverbrauch.

- Dauer der Nutzung: Lange Trainingszeiten erhöhen den CO2- Fußabdruck erheblich, insbesondere bei großen Modellen.

- Power Usage Effectiveness (PUE): Der PUE ist eine Kennzahl, die angibt, wie viel zusätzliche Energie benötigt wird, um die Infrastruktur eines Rechenzentrums (z. B. Kühlsysteme, Beleuchtung) zu betreiben. Je niedriger der PUE-Wert, desto mehr Energie wird direkt für die Berechnungen verwendet.

- Strommix: Der Anteil erneuerbarer Energien im genutzten Stromnetz ist entscheidend für die Emissionshöhe. Regionen mit fossilen Brennstoffen im Strommix führen zu deutlich höheren Emissionen.

Diese Einflussfaktoren allesamt zu berücksichtigen, kann eine Herausforderung darstellen. Deshalb habe ich einen Leitfaden mit Best Practices für die Messung des CO2-Fußabdrucks ausgearbeitet. Denn um im Sinne der Sustainable AI den CO2-Fußabdruck bestmöglich reduzieren zu können, muss dieser zunächst so akkurat wie möglich gemessen werden.

Best Practices für die Messung des CO2-Fußabdrucks

Unternehmen und Entwickler von KI-Modellen können konkrete Maßnahmen umsetzen, um eine genauere Schätzung des CO2-Fußabdrucks zu bekommen:

Geeignetes Messtool

Der CO2-Tracker CodeCarbon bietet aus einer Auswahl von untersuchten Tools die beste Kompatibilität mit verschiedener Hardware und externen Tools. Des Weiteren bietet er die meisten Features für die Messung an.

Messmethode

Einige Tracking-Tools bieten sowohl eine systemweite als auch eine prozessbasierte Messung an. Bei der prozessbasierten Messung wird der Energieverbrauch so gut wie möglich auf Prozesse eingegrenzt, die mit dem ML-Training direkt in Verbindung stehen. Die Wahl hängt dabei von den individuellen Zielen für die Messung ab.

Messintervall

Es ist empfohlen, ein Messintervall zwischen 10 und 15 Sekunden zu wählen. Längere Intervalle beeinflussen die Genauigkeit des Messergebnisses möglicherweise negativ. Kürzere Intervalle sind nicht nötig, können aber ausgewählt werden, da die Messtools den Energieverbrauch nicht messbar beeinflussen.

CO2-Intensität

Um die CO2-Emissionen zu ermitteln, wird der gemessene Stromverbrauch mit der CO2-Intensität multipliziert. Die CO2-Intensität kann die berechneten CO2-Emissionen um über den Faktor 50 erhöhen oder senken. Die Quelle für diese sollte somit möglichst genau sein. Wenn möglich, sollten lokale Daten abgefragt werden oder gängige Services wie Electricity Maps verwendet werden.

Analyse der Messwerte

Um eine geeignete Analyse der Messwerte durchzuführen, ist es wichtig, diese zu visualisieren. Das Tracking-Tool CodeCarbon bietet dafür eine eigene API sowie eine Prometheus- und LogFire-Integration, welche es von anderen Trackern abhebt.

Best Practices für nachhaltiges Machine Learning

Da wir jetzt wissen, wie die Messung des CO2-Fußabdrucks durchgeführt wird, können wir nun zu den Best Practices für die Reduktion übergehen. Diese Best Practices wurden, wie oben beschrieben, anhand einer Sentiment-Analyse mit distilBERT durchgeführt und können deshalb je nach Use-Case oder Modell abweichen.

Energieeffiziente Infrastruktur

Falls Cloud-Services genutzt werden, sollte ein Anbieter mit nachhaltigem Energiemix und möglichst niedrigem Power Usage Effectiveness (PUE)-Wert gewählt werden. Falls verfügbar, sollte auf klimaneutrale Cloud-Anbieter zurückgegriffen werden.

Zudem sind bei lokalen Trainingsprozessen GPUs oder TPUs einer CPU vorzuziehen, da diese für maschinelles Lernen optimiert sind und eine deutlich höhere Energieeffizienz aufweisen. Das Training auf GPUs kann dabei 7 bis 16 mal energieeffizienter sein. TPUs wiederum sind bis zu 10 mal energieeffizienter als GPUs.

Optimale Taktfrequenz

Bei einer Erhöhung der Taktfrequenz der GPU erhöht sich auch deren Stromverbrauch. Gleichzeitig werden allerdings auch mehr Rechenoperationen pro Sekunde durchgeführt, wodurch sich die Trainingsdauer reduziert. Durch die geringere Trainingsdauer wiederum verringert sich der Gesamtenergieverbrauch. Diese beiden gegenläufigen Effekte bilden einen Optimalpunkt, an dem der Stromverbrauch der GPU und die Trainingsdauer genau so hoch sind, dass der Gesamtenergieverbrauch der Trainings am geringsten ist. Dieser Optimalpunkt muss je nach Hardwarekonfiguration mithilfe von eigenen Messungen gefunden werden.

Hyperparameter-Optimierung

In meiner Bachelorarbeit habe ich verschiedene populäre Hyperparameter und deren Einfluss auf den Energieverbrauch analysiert:

Batch Size: Eine höhere Batch Size führt zu einer geringeren Trainingsdauer und somit zu einem geringeren Energieverbrauch. Der mit der höheren Batch Size verbundene höhere GPU-Auslastung ist dabei zu vernachlässigen.

Anzahl der Epochen: Der Energieverbrauch steigt proportional mit der Anzahl der Epochen. Es sollte demnach abgewogen werden, ob sich die Verbesserung der Modellqualität im Vergleich zum Energieverbrauch lohnt.

Anzahl der Trainingsdaten: Die Anzahl der Trainingsdaten verhält sich ebenfalls proportional zum Energieverbrauch und der Trainingsdauer. Wie bei der Anzahl der Epochen auch, sollte abgewogen werden, ob eine Steigerung der Anzahl der Trainingsdaten in Bezug auf die Modellqualität und den Energieverbrauch lohnenswert ist.

Indirekter Einfluss: Hyperparameter wie die Lernrate haben keinen direkten Einfluss auf den Energieverbrauch oder die Trainingsdauer. Sie beeinflussen die Modellqualität allerdings erheblich und können dadurch zu einer wesentlich höheren Trainingsdauer oder sogar zu einem Abbruch und Neustart der Trainings führen. Dadurch wird der Energieverbrauch indirekt signifikant beeinflusst.

Early Stopping

Early Stopping ist besonders effektiv, um die Trainingsdauer bei gleichbleibender Modellqualität zu reduzieren und verringert somit auch den Energieverbrauch erheblich.

Mixed Precision

Der Einsatz von Mixed Precision (FP16) kann die benötigte Trainingsdauer um den Faktor 2 bis 5 reduzieren. Ebenfalls ermöglicht es eine Verarbeitung größerer Batches, womit die Trainingsdauer noch stärker sinkt. Durch die geringere Trainingsdauer sinkt der Energieverbrauch deutlich, ohne die Modellqualität merklich zu beeinflussen.

Energieeffiziente Trainingsmethoden

Man sollte auf Hyperparameter-Optimierungsalgorithmen wie Grid Search verzichten. Stattdessen sollten energieeffizientere Algorithmen wie Random Search oder Bayesian Search eingesetzt werden.

Kompakte Modelle

Techniken wie Quantisierung und Pruning können helfen, Modelle deutlich kleiner und energieeffizienter zu machen. Dabei muss allerdings auf eine sorgfältige Durchführung dieser Techniken geachtet werden, da diese sonst möglicherweise zu einer geringeren Modellqualität führen können.

Sustainable AI in der Praxis

Immer mehr Unternehmen setzen auf Sustainable AI. Beispielsweise hat Google durch den Einsatz von TPUs die Energieeffizienz seiner ML-Modelle erheblich gesteigert. Firmen wie OpenAI, Google oder Microsoft haben angekündigt, ihre Rechenzentren zukünftig vollständig mit erneuerbaren Energien zu betreiben.

Fazit

Sustainable AI ist keine Option mehr, sondern eine Notwendigkeit. Durch eine bewusste Optimierung der Modelle und den Einsatz effizienter Hardware können Entwickler den Energieverbrauch drastisch reduzieren. Unternehmen sollten CO2-Messungen in ihre Workflows integrieren und nachhaltige Praktiken fördern.

Wenn wir KI verantwortungsvoll weiterentwickeln, können wir nicht nur leistungsstarke, sondern auch umweltfreundliche Technologien schaffen.